Instalando e Configurando o Ollama no Windows #

Ollama é uma plataforma que permite rodar modelos de linguagem (LLMs) localmente no seu computador de forma simples e rápida, sem depender da nuvem. Com ele, você pode baixar e interagir com modelos como LLaMA, Mistral e Gemma diretamente via terminal ou API, garantindo mais privacidade, controle e desempenho nas aplicações de IA.

Baixar e Instalar o Ollama #

- Acesse o site oficial do Ollama: https://ollama.com

- Clique no botão de download para Windows e baixe o instalador.

- Execute o instalador e siga as instruções na tela para completar a instalação.

💡 O instalador configura o Ollama para iniciar automaticamente com o sistema e instala uma aplicação de desktop para facilitar o gerenciamento do servidor.

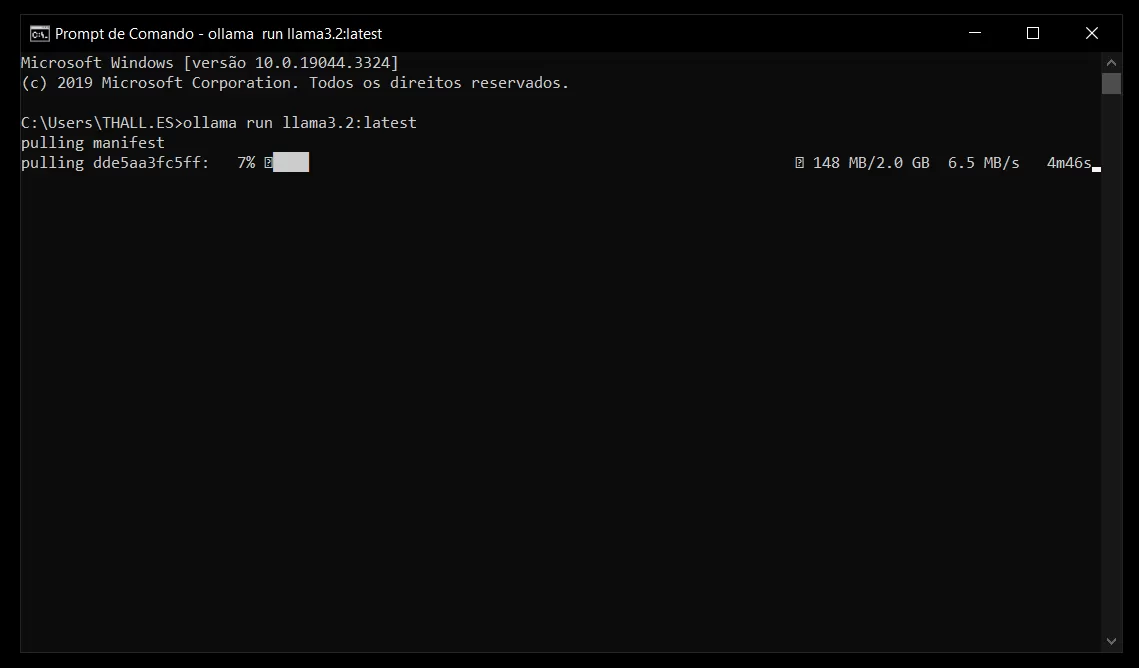

Baixar Modelos de Linguagem #

Com o Ollama instalado, você pode baixar modelos de linguagem para uso local. Abra o Prompt de Comando ou o PowerShell e execute os seguintes comandos conforme necessário:

- Llama 3.2 (1B):

ollama run llama3.2:latest

Outros modelos recomendados:

Gemma 2 (2B):

ollama run gemma2:2b

Mistral (7B):

ollama run mistral

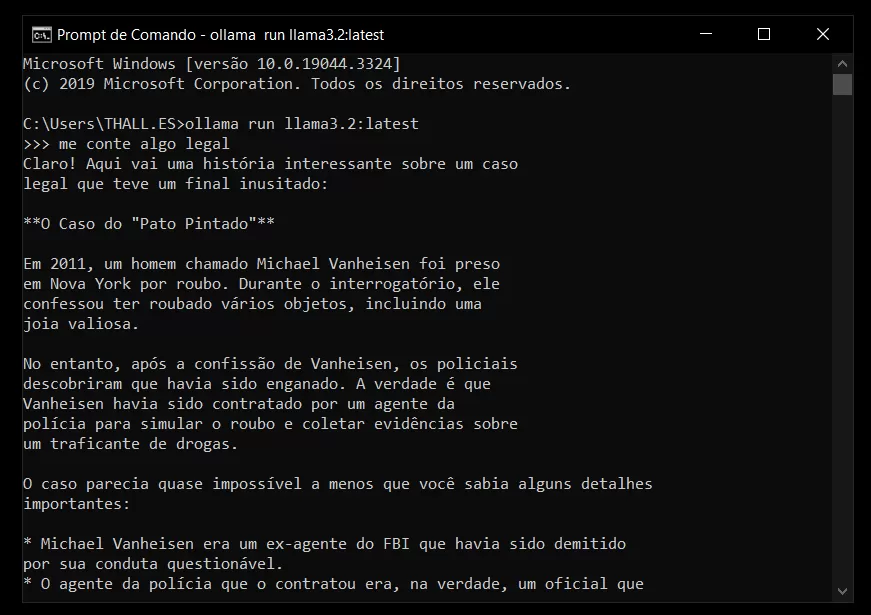

Como Abrir e Usar o Ollama #

Para conversar com a IA, você pode abrir o CMD (Prompt de Comando no Windows) e usar o mesmo comando usado para baixar o modelo de linguagem.

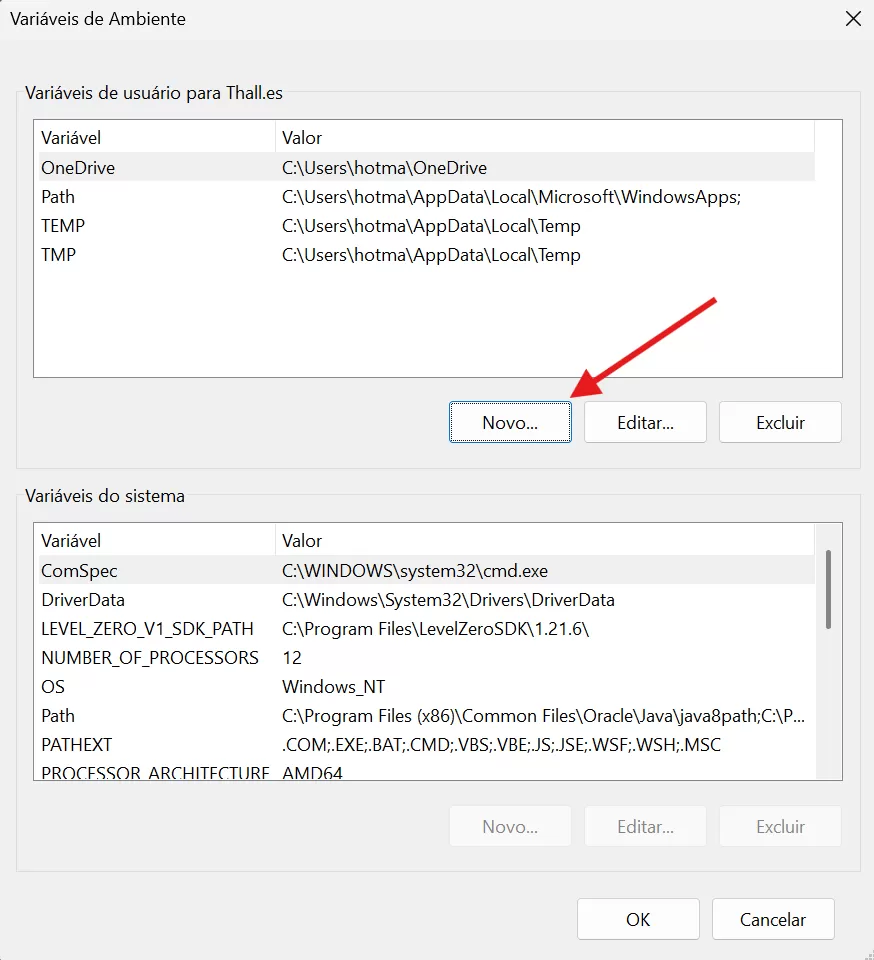

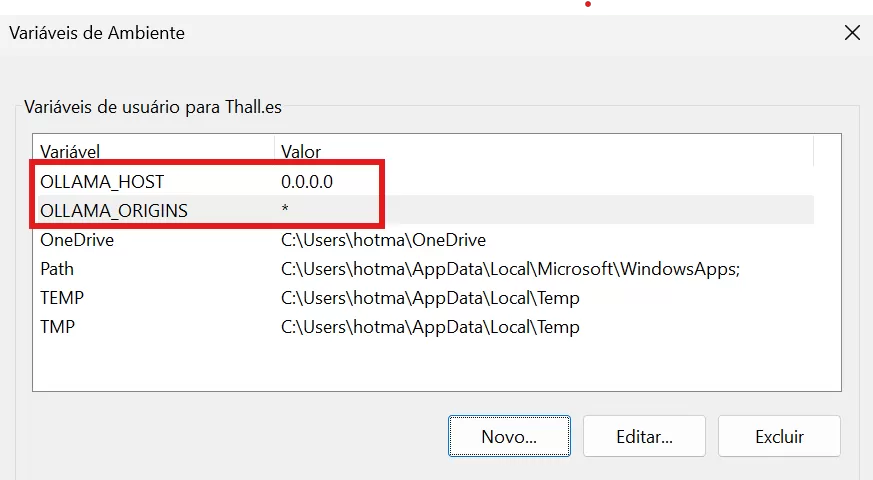

Configurando OLLAMA_HOST e OLLAMA_ORIGINS #

Para permitir que o Ollama aceite conexões de outras origens, siga os passos abaixo:

- Encerrar o Ollama:

- Clique com o botão direito no ícone do Ollama na bandeja do sistema (próximo ao relógio) e selecione “Sair”.

- Abrir as Configurações de Variáveis de Ambiente:

- Pressione Win + S, digite “variáveis de ambiente” e selecione “Editar variáveis de ambiente do sistema”.

- Adicionar Variáveis de Ambiente:

- Na seção “Variáveis de usuário”, clique em “Novo…” e adicione as seguintes variáveis:

- Nome da variável: OLLAMA_HOST

- Valor da variável: 0.0.0.0

- Clique novamente em “Novo…” e adicione:

- Nome da variável: OLLAMA_ORIGINS

- Valor da variável: *

- Salvar e Reiniciar o Ollama:

- Clique em “OK” para salvar as alterações.

- Inicie o Ollama novamente a partir do menu Iniciar.

🔒 Essas configurações permitem que o Ollama aceite conexões de qualquer origem. Para ambientes de produção, é recomendável restringir as origens permitidas por motivos de segurança.