Instalación y configuración de Ollama en Windows #

Ollama es una plataforma que te permite ejecutar modelos de lenguaje (LLMs) localmente en tu ordenador de forma sencilla y rápida, sin depender de la nube. Con él, puede descargar e interactuar con modelos como LLaMA, Mistral y Gemma directamente a través de terminal o API, lo que garantiza más privacidad, control y rendimiento en las aplicaciones de IA.

Descargar e instalar Ollama #

- Visita el sitio web oficial de Ollama: https://ollama.com

- Haga clic en el botón de descarga para Windows y descargue el instalador.

- Ejecute el instalador y siga las instrucciones en pantalla para completar la instalación.

💡 El instalador configura Ollama para que se inicie automáticamente con el sistema e instala una aplicación de escritorio para facilitar la administración del servidor.

Descargar modelos lingüísticos #

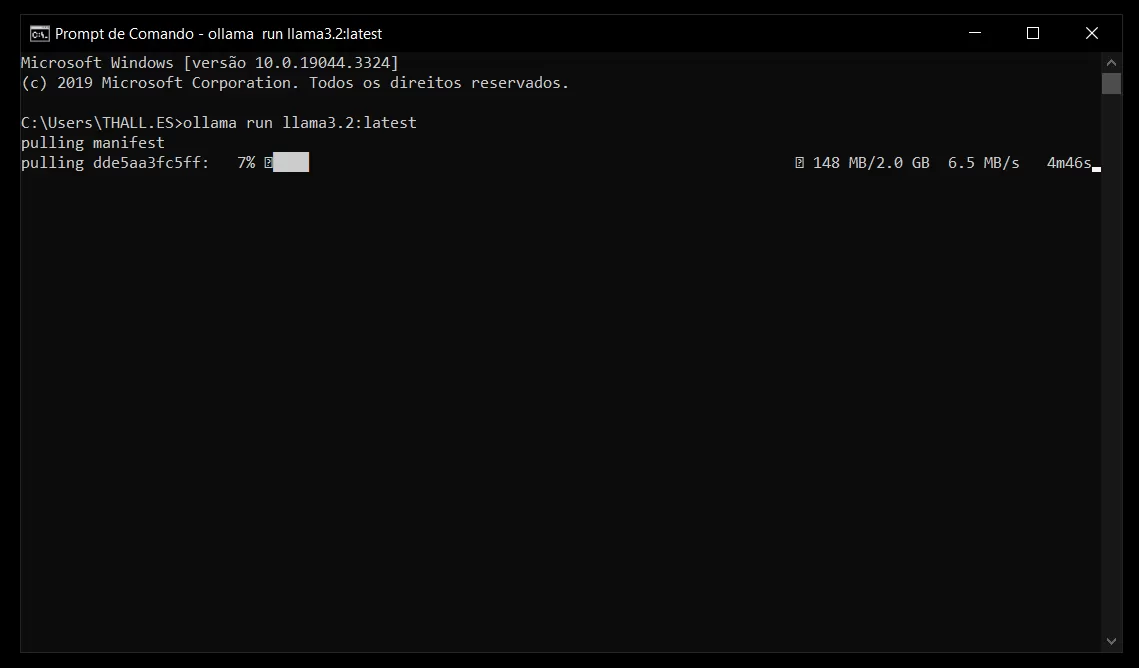

Con Ollama instalado, puede descargar modelos de lenguaje para uso local. Abra el símbolo del sistema o PowerShell y ejecute los siguientes comandos según sea necesario:

- Llama 3.2 (1B):

ollama run llama3.2:latest

Otros modelos recomendados:

Gemma 2 (2B):

ollama run gemma2:2b

Mistral (7B):

ollama run mistral

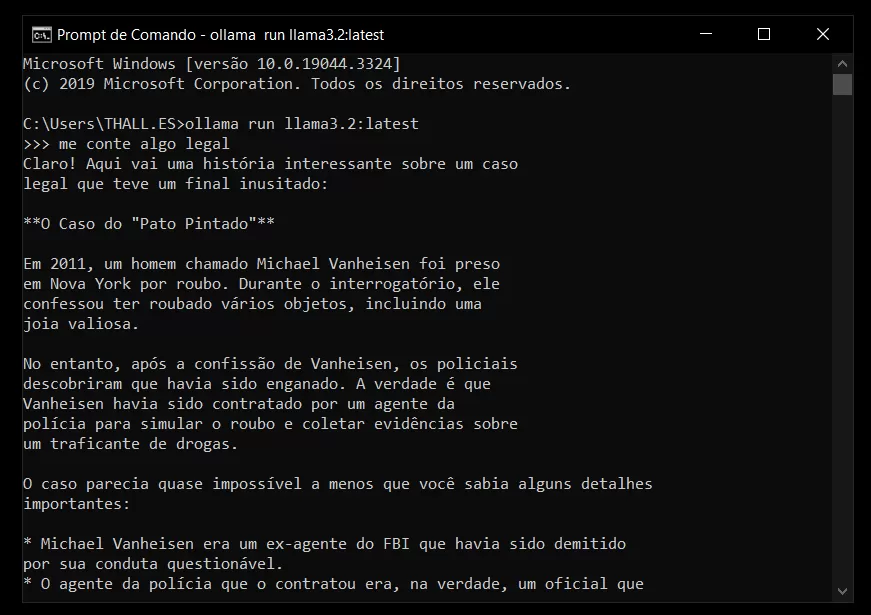

Cómo abrir y usar Ollama #

Para hablar con la IA, puede abrir el símbolo del sistema (CMD) en Windows y usar el mismo comando que usó para descargar el modelo de lenguaje.

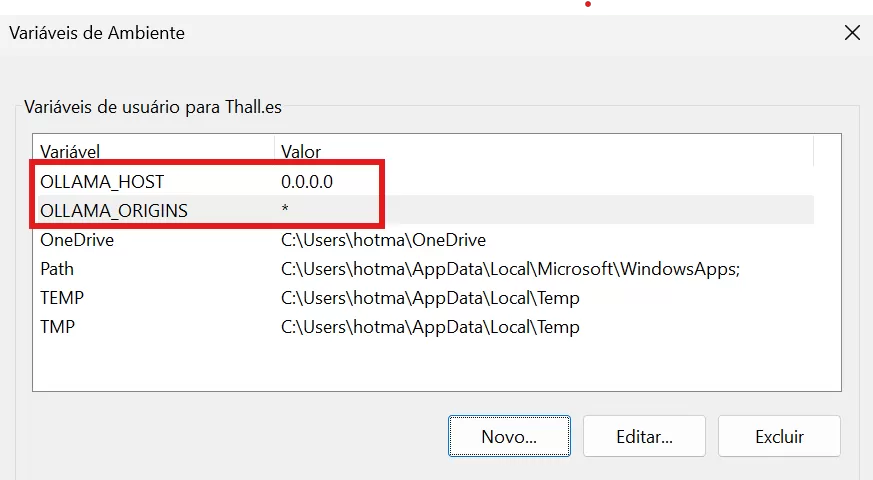

Configuración de OLLAMA_HOST y OLLAMA_ORIGINS #

Para permitir que Ollama acepte conexiones de otras fuentes, siga los pasos a continuación:

- Apaga Ollama:

- Haga clic con el botón derecho en el icono de Ollama en la bandeja del sistema (junto al reloj) y seleccione “Salir”.

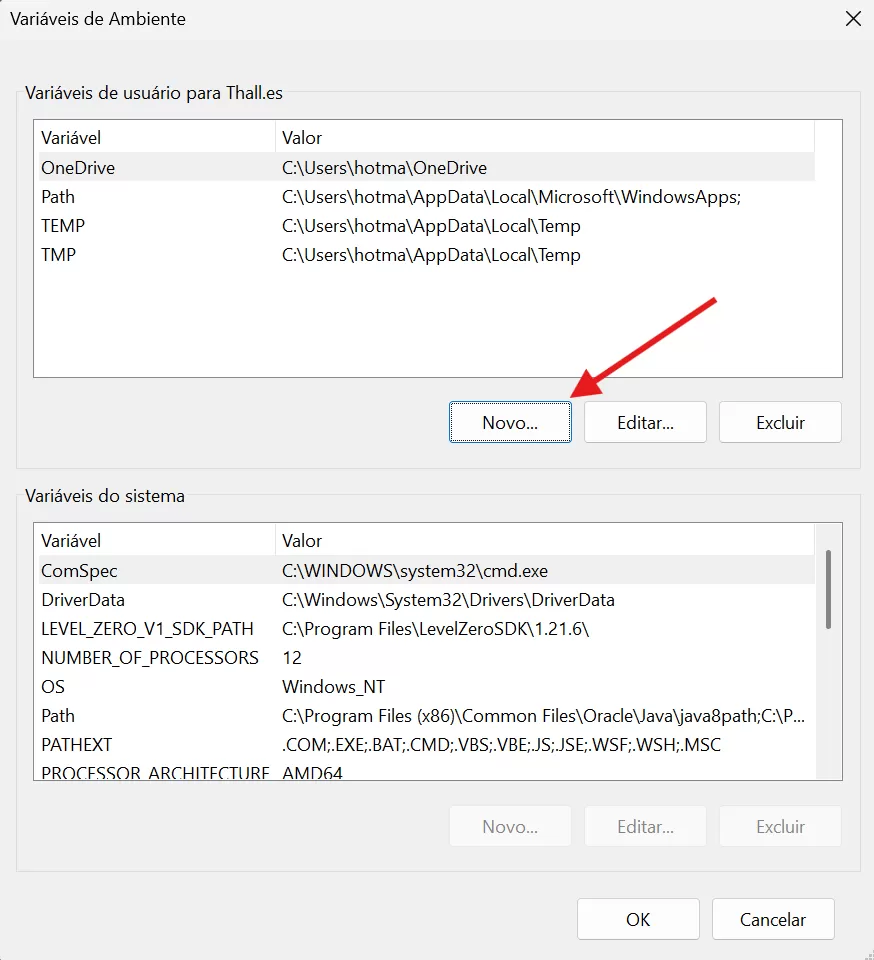

- Abra la configuración de variables de entorno:

- Presione Win + S, escriba “variables de entorno” y seleccione “Editar variables de entorno del sistema”.

- Agregar variables de entorno:

- En la sección “Variables de usuario”, haga clic en “Nuevo…” y agregue las siguientes variables:

- Nombre de la variable: OLLAMA_HOST

- Valor de la variable: 0.0.0.0

- Haga clic en “Nuevo…” y añade:

- Nombre de la variable: OLLAMA_ORIGINS

- Valor de la variable: *

- Guardar y reiniciar Ollama:

- Haga clic en “Aceptar” para guardar los cambios.

- Vuelva a iniciar Ollama desde el menú Inicio.

🔒 Esta configuración permite a Ollama aceptar conexiones de cualquier fuente. Para entornos de producción, se recomienda restringir los orígenes permitidos por razones de seguridad.